« July 2006 | Главная | September 2006 »

August 31, 2006

Обработка noindex в мета-теге robots

Мэтт Каттс исследовал реакцию разных поисковых систем на тег

<meta name="robots" content="noindex, nofollow" />

Результаты следующие:

- Google никак не отображает ссылку на эту страницу

- Ask также не отображает ссылку

- MSN отображает ссылку без сниппета и ссылку на кеш страницы, по клику на кеш ничего не отображается

- Yahoo отображает ссылку без сниппета и ссылку на кеш версию, по клике на кеш отображает закешированную страницу

Хорошее дело такие проверки, надо для русскоязычных поисковиков устроить аналогичную проверку. Ни у кого нет желания?

Отправлено Cherny в 10:40 AM | Комментарии (2)

August 30, 2006

Денни Салливан покидает SEW и SES

Только ленивый еще не написал о том, что Денни Салливан покидает SEW. Я ленивый, если кто не в курсе. Если кто не в курсе, кто такой Денни Салливан, то дальше можно не читать, в принципе.

Мэтт Каттс назвал уход Денни earthquake, что можно перевести, как потрясение, здесь это называют шоком для индустрии SEO, на SEOMoz анализируют последствия для рынка SEO.

Денни Салливан — основатель ресурса Search Engine Watch и конференций Search Engine Strategies, с прошлого года принадлежащих компании Incisive Media, с 1997 года по 2005 владельцем ресурсов была компании JupiterMedia. Контракт Денни заканчивается 30 ноября этого года.

Отправлено Cherny в 9:34 AM

August 29, 2006

Конструктор портала от Google

Гугл предлагает для установки на доменах пользователей четыре своих сервиса: почту на основе GMail, IM на основе Google Talk, календарь на основе Google Calendar и средство публикации страниц на основе Google Page Creator. Оформление, как то цветовые схемы, логотипы и прочее можно изменять, о хостинге и функциональности Гугл позаботится.

Как-то одному человеку понравилась моя фраза, что пользователи продолжают переносить свои данные на датацентры Гугля. Таки продолжают!

И еще рекомендую «Заметки разработчика поисковых сервисов», очень интересный журнал!

Отправлено Cherny в 8:57 AM | Комментарии (2)

Google Wireless Transcoder

Несмотря на большое количество различных лог-анализаторов и сервисов обсчета статистики, в том числе и заточенных под SEO, стоит иногда просто проглядывать логи.

Вот, например, выловился интересный зверь Google Wireless Transcoder. robots.txt он не запрашивает, никакого поясняющего URL в User-agent не указано.

Оказывается это специальный агент Google, подготавливающий контент для мобильников, причем не сканирующий, а именно преобразующий, не зря упоминается Transcoder.

Из особенностей поведения следует отметить несколько запросов графики с пустыми полями Referer и User-agent с того же IP. То есть забирается вся страница с графикой и преобразуется на лету, но при этом JavaScript не исполняется. CSS-ом тоже не интересуется.

Полный User-agent: Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.0; Google Wireless Transcoder;)

Таким образом можно отловить читателей через мобильные устройства, нашедших контент в Гугле, только вот поискового запроса нет.

Отправлено Cherny в 12:47 AM

August 28, 2006

Очередной апдейт Yahoo

По уже сложившейся традиции Yahoo сообщает об апдейтах в своем блоге. Попутно зазывают вебмастеров регистрироваться в Site Explorer.

Отправлено Cherny в 10:05 AM

August 15, 2006

Приоритеты обработки записей в robots.txt

Как много девушек хороших, а нас все тянет на плохих

Barry Schwartz дает ссылки на обсуждения приоритета выбора записей в robots.txt роботами поисковых систем.

Меня всегда удивляло, как можно делать такие разные и вычурные ошибки в таком простом файле исключений с четким и однозначным форматом? Можно, конечно, грешить на большое количество расширений, которые добавляет в стандарт каждая значимая система с широко известными в узких кругах именами роботов: Google, Yahoo, MSN, Yandex. Но в таком случае и вопросы по robots.txt возникали бы прежде всего именно по расширениям.

Вернемся к приоритетам. Как известно, записи в robots.txt разделяются пустыми строками, каждая запись — это инструкция для одного или нескольких роботов. Пусть мы имеем следующее содержание файла исключений:

User-agent: *

Disallow: /dir/file

User-agent: Yandex

Disallow: /reports

User-agent: Googlebot

Disallow: /users

Allow: /best-page.html

Вопрос заключался в том, какими директивами в данном случае будет руководствоваться робот Гугля, что для него будет запрещено? Можно подумать, что робот наткнется в первую очередь на секцию для всех роботов и именно ее правила примет к рассмотрению. Это неверное предположение. Робот при парсинге файла работает примерно по следующему алгоритму:

- Получает полностью файл

- Выделяет в файле корректные секции

- Ищет "свою" секцию

- Если своя секция найдена принимает к руководству ее инструкции.

- Если своей секции не обнаружено, ищет секцию для всех роботов

- Если обнаружена секция для всех роботов, принимает к руководству ее инструкции

- Если общая секция не найдена, робот считает, что индексировать можно все без исключения.

Отсюда делаем сразу несколько выводов:

- Порядок секций в файле значения не имеет.

- Если будет найдена "своя секция", то робот будет руководствоваться только ее инструкциями, игнорируя все остальные, поэтому в нашем примере робот Гугл абсолютно справедливо будет индексировать /dir/file.

- Отсутствие общей секции — разрешение индексировать весь сайт роботам, не упомянутым ни в одной секции.

Пора писать свой сервис проверки, но это ж сколько кодировать надо!

Отправлено Cherny в 10:58 PM | Комментарии (13)

August 8, 2006

GWC - продолжение

Кроме самого сервиса, старый блог тоже переехал на новый адрес.

Остановлюсь подробнее на «фичах» Google Webmaster Central.

Изменения интерфейса

Сам интерфейс претерпел изменения. Более удобно стало просматривать информацию об индексировании, URL, запрещенные для индексации и т.д. На скриншоте я обвел ссылку на новый инструмент по указанию основного зеркала

Выбор основного зеркала сайта

Вот как выглядит форма выбора основного адреса для домена — с www или без.

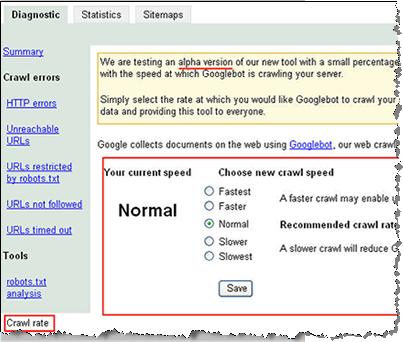

Выбор скорости индексации сайта

Форма выбора скорости индексации сайта в данный момент тестируется и показывается только малому количеству вебмастеров. У меня ссылки на нее нет, скриншот взял отсюда.

Статистика индексации самого Google

На следующем скриншоте из блога GWC можно рассмотреть статистику индексации Гуглом самого себя:

- HTTP-ошибок: 34

- Не найдено: 13617

- URL time out: 6

- Недоступных адресов: 1151

- Запрещено в robots.txt: 1493507

Отправлено Cherny в 9:20 AM | Комментарии (1)

August 7, 2006

Google Webmaster Central

В конце прошлой недели было объявлено о переименовании, или, как сейчас модно говорить, ребрендинге Google Sitemaps, на котором и был основан новый сервис, получивший название Google Webmaster Central.

Google продолжает поворачиваться к вебмастерам лицом! :)

Я отмечал полезность Google Sitemaps в своем докладе на майской конференции в Киеве, сервис продолжали развивать и усовершенствовать, сейчас интерфейс отслеживания ошибок на сайте стал более удобным и добавилось несколько новых инструментов. Наиболее интересный и важный — указание главного зеркала для домена, с www или без. Так что важность организации 301-го редиректа для Google несколько снизилась, хотя во многом он нам еще пригодится.

Несколько инструментов еще тестируются, например выбор скорости индексирования сайта.

Отправлено Cherny в 10:10 PM

August 4, 2006

Yahoo ищет SEO-специалиста

Немецкое отделение Yahoo ищет SEO-специалиста. (via)

Все рабочие обязанности и требования к соискателю внятно расписаны. Возникает только вопрос о продвижении продуктов Yahoo в самом Yahoo и знании особенностей алгоритма нанимателя! :)

Отправлено Cherny в 9:17 AM

Сериал о Google

Мэтт Каттс выложил целый сериал небольших видеообращений с ответами на ряд вопросов от вебмастеров. Довольно интересных вопросов, кстати.

Воспринимать на слух можно, хотя и не все сразу понятно. Добрые люди, однако, стенографировали и выкладывали в виде текстов (еще не все), так что нет необходимости вновь и вновь прокручивать видео.

Юмор в ответах обнаруживается, например часть ответа на вопрос о сравнении влияния тегов <b> и <strong> следует воспроизводить примерно так:

...потому что тег <b> использовали все с давних времен (когда динозавры бродили по Земле), а <strong> рекомендует использовать W3C. В настоящее время, прошлой ночью (30 июля 2006 года) я думал, что Google немножко, немножко, немно-о-ожко — как эпсилон — отдает больше приоритета тегу <b>, и я сказал, что по большей части не стоит об этом беспокоиться.

Однако хорошая новость заключается в том, что инженер показал мне часть кода, и я смог лично удостовериться, что Google учитывает теги <b> и <strong> с абсолютно одинаковым приоритетом...

В любом случае обязательно прослушать, прочитать, осознать, сделать выводы! Но это уже не сегодня, следите за анонсами.

Отправлено Cherny в 12:20 AM

August 3, 2006

Специально для Блогуса

Люди, не читайте это! Специально для Блогуса: Салям Алейкум!c953f00b-b0f3-47df-a7b5-dd4f2516cf52

Отправлено Cherny в 11:21 PM

August 2, 2006

1024x768 - самое распространенное разрешение

Якоб Нильсен называет разрешение 1024x768 наиболее распространенным и предлагает делать дизайн в первую очередь именно для него, но так, чтобы и других не обидеть:

Optimize Web pages for 1024x768, but use a liquid layout that stretches well for any resolution, from 800x600 to 1280x1024.

Я бы еще отметил «нестардантные» разрешения, связанные с популяризацией широких экранов с соотношением сторон 16:9, а не стандартных с соотношением 4:3.

А владельцы больших мониторов с большими разрешениями навряд ли разворачивают сайты на весь экран — шея будет болеть после такого чтения. Я помню, как тяжело было ставить NT 4.0 на машину с 21-дюймовым монитором, 640х480 там было просто издевательством.

Расскажу дизайнеру, все равно еще не спит!

Update: ответили, что я отстал от жизни... :)

Отправлено Cherny в 12:28 AM | Комментарии (5)

msnbot переименовали

Робота поисковой системы от Майкрософт переименовали, вернее отпочковали от него узкоспециализированных агентов, в частности:

msnbot-products — бот «Shopping», не знаю очем речь, подскажите, кто в курсе;

msnbot-news — новостной робот;

msnbot-media — робот поиска по изображениям, теперь можно для экономии запретить индексацию сайта роботу для картинок, но открыть всем остальным;

msnbot — робот для основного поиска.

Отправлено Cherny в 12:05 AM

August 1, 2006

Особенности запуска украинских веб-проектов

Купить яблоко, помыть, высушить до блеска натереть его, продать.

На заработанные деньги купить еще одно яблоко, помыть, высушить, до блеска натереть и продать.

...Еще пару яблок, оставляющих в логах строки с подписью Robot Verter...

После этого умирает (возможно не по собственной воле) богатый дедушка c 15 тыс. ежедневного трафика.

Отправлено Cherny в 12:13 AM

Как работает Google News

Филипп Ленссен тезисно описывает принципы работы Google News. Переводить не буду, тем более никаких особых откровений там нет. Да и русскоязычной версии сервиса и источников пока нет, будем надеяться, что «пока»!

Следует отметить, что при всей схожести, Яндекс.Новости функционируют несколько по другому в области получения новостного контента.

Отправлено Cherny в 12:03 AM